Gaussian Process Latent Variable Models for Visualisation of High Dimensional Data (GPLVM)

GPLVM 是一个对高维数据降维的方法.根据作者的talks,应该被命名为 probablistic dimentional reduction.

数据降维最为基础的思路就是找出数据中方差最大的主线性轴, 也就是 PCA算法的结果.

本文首先尝试从概率角度对PCA进行重新描述,并提出更通用的GPLVM.

Linear Probabilistic PCA (PPCA)

- 数据与 latent variables之间有线性高斯关系,

- 已知latent variables 满足高斯分布

- Marginalize w.r.t.

前人分析发现这个PPCA的的解与PCA的一致.

Dual Probabilistic PCA (Dual PCA)

- 数据与 latent variables之间有线性高斯关系

- 已知 参数满足高斯分布

- Marginalize w.r.t.

对应的 log-likelihood 是

使关于的导数为零,可以求得满足以下方程

观察前面的式子可以发现, 数据的分布变为了以零为期望,由latent variable组成的协方差矩阵. 一个自然的延伸就是假设这个协方差矩阵是由通用的可能非线性的核函数替代。

GPLVM

如将核函数设定为 RBF 指数核:

损失函数关于核函数的导数仍然没有变化,可以通过一阶优化方法迭代得到local minima解.

实际执行

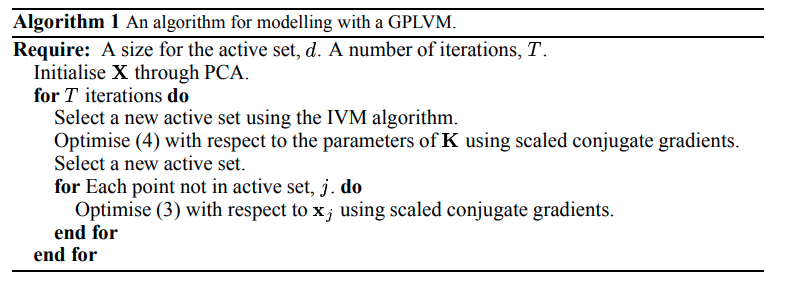

实际执行GPLVM的时候可以采取一些技巧减少运算量:

- 稀疏化: 仅用部分数据(active set)计算协方差矩阵拟合高斯过程模型. 选择方法依据: 作者的另一篇关于sparcity & GP的文章

- latent variable优化:从 active set 得到协方差之后,用高斯过程推理的方法得到每一个数据的forward pass, 其梯度仅与自己以及其他active set中的数据有关,因而所有 inactive set中的数据可以并行求解得到自己对应的latent variable.

Extension: Unified Objective Function

这里指出可以用一个 KL divergence来统一 PCA, kernel PCA, PPCA, GP-LVM, 它们分别对应对的不同设置.