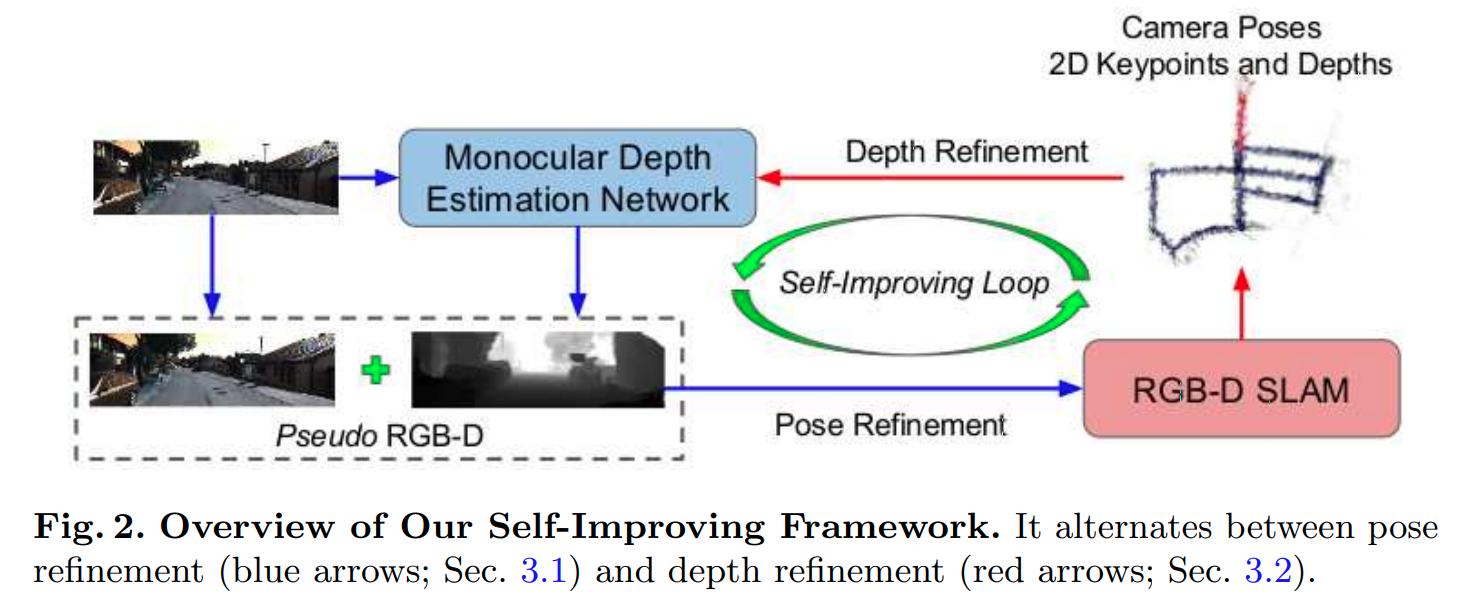

Pseudo RGB-D for Self-Improving Monocular SLAM and Depth Prediction

这篇paper融合了单目无监督的深度预测以及SLAM,在训练数据只有单目视频的情况下完成对单目深度预测的训练以及SLAM。

对SLAM使用的优化

本文使用的SLAM基准是RGB-D 版本的 ORB-SLAM, 在RGBD设定下,ORB-SLAM会将depth图转换为disparity 图,从而复用Stereo-ORBSLAM的框架。需要设定虚拟双目的基线,对每一个输入序列,先计算网络预测的最大深度, baseline的设定:

深度优化

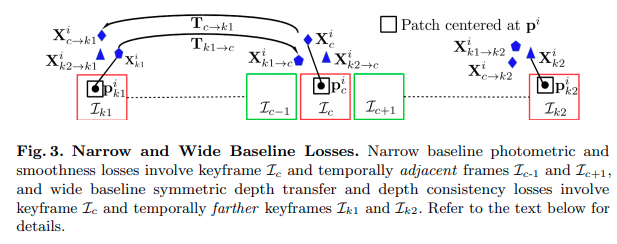

网络深度的网络是MonoDepth2, 但是优化的方法进一步考虑长期的consistency,

图片中为 keyframes.

Depth Transfer Loss

也即是将帧的通过SLAM得到的3D keypoint通过SLAM得到的transformation 转移到帧视角中,要求两者的深度预测值相等。反方向的转换亦然。

transfer loss同样作用于

Depth Consistency Loss

Photometric Reconstruction Loss

利用的深度,相对位移用帧的图像重建帧的图像,按照MonoDepth2的paper计算损失