Direct Loss Minimization

本文集中分析几篇与direct loss minimization相关的文章。其最终反应的直观解释是在task-based loss或者reward的引导下让网络向更高的输出权重靠拢。

通常优化问题的目标是找到, 使得,也就是目标输出与基于权重的输出差距最小. 当相对于是不可导的时候,无法反传。

与得到task-related loss直接回传不同,它的思路是根据task-related loss以及网络本身的输出,搜索出可能更好的一组输出, 然后学习算法的训练函数则是引导模型的输出远离, 靠近.

核心 Motivation 与奠基: Direct Loss Minimization for Structured Prediction

这篇2010的NIPS从两个角度引入了 direct loss minimization.

- Perceptron Training Algorithm

- Structural SVM

Perceptron的算法本站在此处由简介.本文重述为

其中为线性权重,为特征矢量.这个基础的更新法则是与Loss无关的.

Structural SVM的广义优化问题为:

一个解法是先计算出hinge loss里面内的的取值 . 权重更新可以写为

作者进一步加入了参数

作者主要结果就是证明了,当逼近零的时候,更新方向逼近于

也就是说,

其中

Training Deep Neural Networks via Direct Loss Minimization

这篇paper是AP-Loss的引文之一. 提出了使用 Direct Loss minimization,用AP作为引导训练分类网络。

取前文的优化问题的处理,设置Task Loss 。是网络直接的输出 logits. 梯度

重点难点在于计算

其技巧并不通用(目前情况来说显著地比不上AP-Loss的算法)。不在本站展开.

Direct Policy Gradients: Direct Optimization of Policies in Discrete Action Spaces

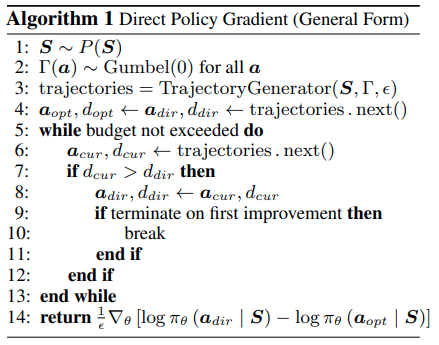

这篇NIPS2020 paper则将Direct Loss minimization用到了policy gradient上,处理离散的action spaces。巧妙的地方在于使得A*的剪枝-加速搜索的方法应用到了强化学习中。

由于需要对行动进行采样,又进一步引入了 Gumbel-reparametrization

Policy Gradient

Direct Policy Gradient

与基础的policy gradient直接从采样不同,本文的输出action定义为

其中 是gumbel随机采样值

设action 的采样是基于二元函数, 进而修改得到梯度结果

其中是不考虑梯度结果,网络模型原来的输出采样出来的结果,这里文章称之为. 是带有reward时推理的结果,与direct loss minimization 范式对照,这里称之为

搜索算法:

作者进一步考虑到可以使用 heuristic function 在搜索最佳的的过程中使用 A*修剪掉expected results比较低的部分,加快搜索进度.