A Ranking-based, Balanced Loss Function Unifying Classification and Localisation in Object Detection

这篇paper在AP loss的基础上提出了更广义的优化架构以及 average Localization-Recall-Precision (aLRP) loss. 由名字可知,aLRP loss 的主要motivation在于使用单一一个 rank-based loss 同时优化分类与回归。 AP loss是只处理回归问题的。

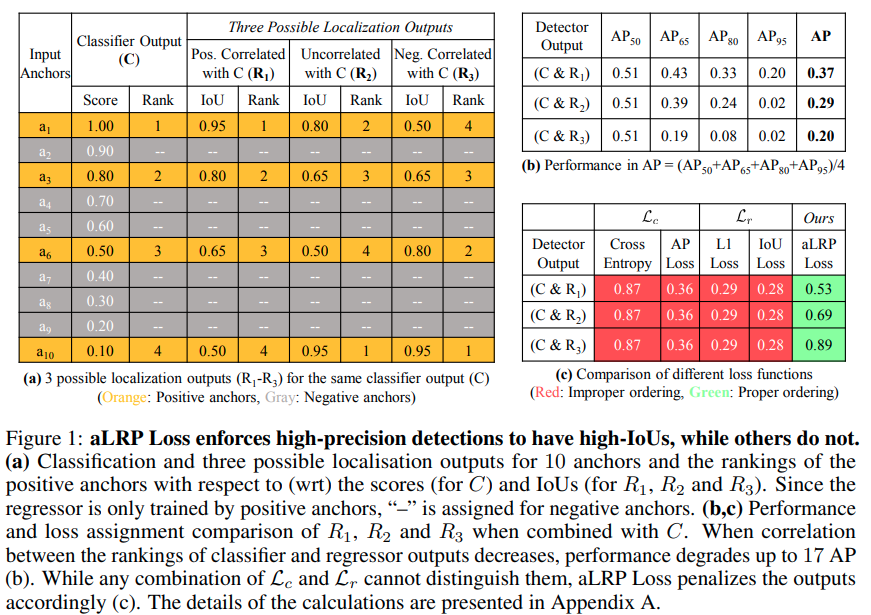

由这张图可以发现,目前目标检测的目标是希望回归数值更准确的样本置信度更高,这样的话可以提升更高IoU threshold时的AP. 也就能提升平均AP. 作者这里给出的一个特殊案例说明当前的各种loss都没有办法引导网络像 中的合理排布靠拢。而本文提出的 aLRP loss 是耦合了分类排序与IoU的损失,因而能区分这种情况。

Review

AP Loss:

Localization-Recall-Precision (LRP) Performance Metric:

其中 , 一般是正负样本的threshold,一般取

这个Metric 与 AP Loss 一样,都是越小越好的。如果 IoU 都为 1, 则这个loss与AP loss 的表达式基本一致。

更通用的 Error-Driving Optimization

作者指出,将AP loss的优化方法扩展到不同的 ranking-based loss上并不简单。

作者这里提出了一个新的定义方案:

- ranking-based loss function 定义为对由一系列正样本对应的loss.

- Primary term

这个定义下,有

- 定理一:

- 定理二:

AP Loss. , 且

aLRP Loss

这可以被分成两项

优化方法:

实验上得到了比所有one-stage detector更高的性能(直接提升4点mAP)。