Exploiting Event Cameras by Using a Network Grafting Algorithm

这篇paper使用知识蒸馏的概念将RGB图中的目标检测能力传递到event camera的检测中。

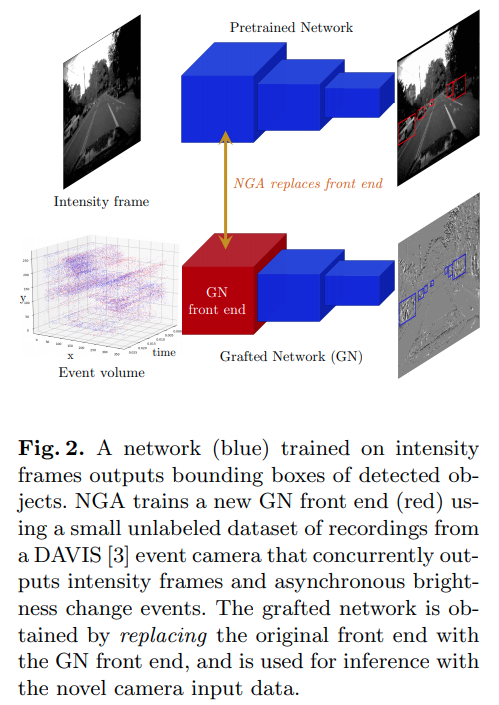

NGA structure

简单来说是用在更大数据集上预训练好的基于RGB的2D object detection来训练数据量更小的event camera 网络。

Event Camera 的Volume表达方式

将一段时间内的event 流按照时间片均匀地分割为块,形成D个channel,每一个channel将这个时间片内的所有event在对应坐标上求和即可。

本文的时间片划分分为D=3与D=10两种

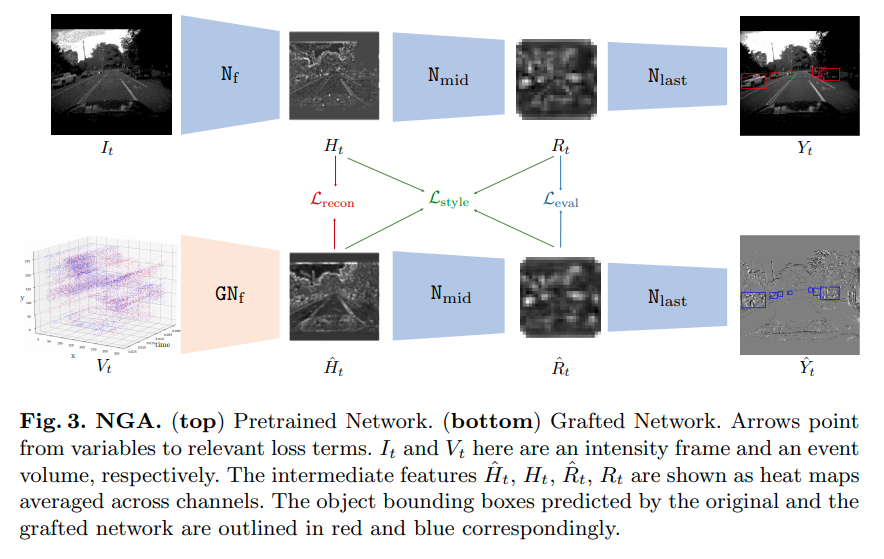

NGA 训练

首先将需要训练的前馈网络分为两层,第一层的输出为,第二层的输出为.

首先将需要训练的前馈网络分为两层,第一层的输出为,第二层的输出为.

对于两个特征图的差的损失,本文提出直接使用MSE

is based on Gram Matrix

最终:

Style loss with Gram Matrix review

The description is much clearer in pdf1.

这里为特征图的形状, 指indexing, 为特征图的gram矩阵。下式说明格拉姆矩阵每一个元素的运算。

Style Loss就是两个特征图格拉姆矩阵的差的二范数

code

keras example for style transfer

def gram_matrix(x):

"""

x.shape = [C, H, W] for 'channels_first'

"""

assert K.ndim(x) == 3

if K.image_data_format() == 'channels_first':

features = K.batch_flatten(x) #[C, H*W]

else:

features = K.batch_flatten(K.permute_dimensions(x, (2, 0, 1)))

gram = K.dot(features, K.transpose(features))

return gram

Network seperation

对于YOLOv3一共5次下采样,分成6段网络,将第二 or 第三段的输出作为,将第四段的输出作为得到的结果较好(重复实验结果)

Other Stuffs

数据集: The MVSEC Dataset,带有深度的双目RGB+双目event stream数据集。

Event dataset from moving static images: https://www.garrickorchard.com/datasets