Infinite-Horizon Differentiable Model Predictive Control

这篇paper与OptNet有很强的关联性.OptNet利用KKT condition对QP问题的推理结果进行反向求导,使得二次规划优化问题的backward阶段不需要被forward阶段的迭代所影响。效率显著提高。

这篇paper则使用了控制领域的一个常见的trick,在使用非线性优化器/复杂算法时,先使用一个可靠的控制器使原来的系统基本稳定,再让额外添加的优化器对残差结果进行回归。

本文使用的预稳定控制器是一个LQR控制器。而LQR中存在有Q,R两个代表各个state与input的损失超参,作者的一个主要贡献就是让这两个损失超参也变成可以被学习的参数,给出了对Riccati方程的导数进行传播的公式。

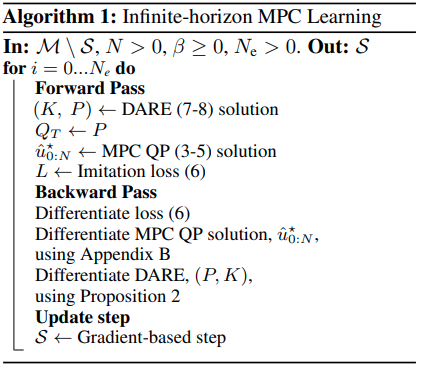

文章的算法框架如图:

MPC Review

对于一个线性系统,步长为的MPC控制,可以划归为以下带有松弛变量(slack variables)的二次优化问题.使得问题总是有解的。

如果将输入控制变量分解为,其中为线性状态反馈矩阵。上述问题变为

将它们重整为QP问题后,可以使用OptNet的模块得到优化结果以及对和的导数。

模仿学习则可以根据优化结果以及专家标注给出损失。

Infinite Horizon Terminal Cost

LQR最优控制器得到的控制结果是针对无限预测步长的LTI系统MPC问题。其为 其中为离散Riccati方程的解: 注意的数学意义,Final cost.本文提出前文的MPC中,用于表达稳态cost的矩阵.

对于选择的MPC,作者证明了一系列好的性质,包括存在有限视界MPC使得无限视界最优,MPC可行性、渐进稳定性,鲁棒性等。

作者提出了与的矢量关系。